Le sous-titrage est une technique efficace pour améliorer l'accessibilité, l'engagement et la mémorisation des informations lors des présentations et des événements en direct. Ce phénomène, conjugué à l'évolution des habitudes de consommation vidéo dans le domaine du streaming, a récemment accéléré l'adoption du sous-titrage automatique par intelligence artificielle lors d'événements en direct et de réunions professionnelles.

Mais lorsqu'il s'agit de choisir un prestataire pour votre propre réunion ou événement, la question qui revient le plus souvent est la suivante : les sous-titres automatiques en direct sont-ils précis ?

La réponse courte est que, dans des conditions idéales, les sous-titres automatiques dans les langues parlées peuvent atteindre une précision allant jusqu'à 98 %, évaluée par le taux d'erreur sur les mots (WER).

Et oui, la réponse est plus longue et un peu plus complexe. Dans cet article, nous vous proposons un aperçu de la mesure de la précision, des facteurs qui l'influencent et des moyens de l'améliorer encore.

Dans cet article

- Comment fonctionne le sous-titrage automatique

- Qu'est-ce qui est considéré comme une bonne qualité de sous-titrage ?

- Quels facteurs influencent la précision ?

- Mesure de la précision du sous-titrage automatique

- Taux d'erreur de compréhension des mots (WER)

- Obtenez un sous-titrage codé d'une précision incroyable pour vos événements en direct

Avant de nous pencher sur les chiffres, prenons un peu de recul et examinons comment fonctionnent les sous-titres automatiques.

Comment fonctionne le sous-titrage automatique

Sous-titres automatiques

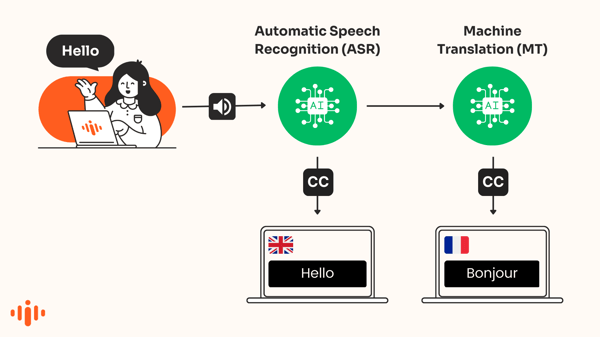

Le sous-titrage automatique convertit la parole en texte qui s'affiche à l'écran en temps réel, dans la même langue. La reconnaissance vocale automatique (ASR) est une forme d'intelligence artificielle utilisée pour produire ces transcriptions de phrases prononcées.

Cette technologie, souvent appelée « transcription vocale », permet de reconnaître automatiquement les mots dans un enregistrement audio et de transcrire la voix en texte.

Sous-titres traduits par IA

Les moteurs de traduction automatique basés sur l'intelligence artificielle traduisent automatiquement les légendes qui apparaissent dans une autre langue. On parle alors de sous-titres traduits automatiquement.

Article recommandé

Pourquoi vous devriez envisager d'ajouter des sous-titres en direct à votre prochain événement

Cet article traite des sous-titres automatiques. Pour en savoir plus sur la précision des sous-titres traduits par IA, consultez cet article .

Qu'est-ce qui est considéré comme une bonne qualité de sous-titrage ?

La Commission fédérale des communications (FCC) a établi en 2014 des caractéristiques essentielles pour déterminer si les sous-titres sont « excellents » :

- Exactitude – Les sous-titres doivent correspondre le plus fidèlement possible aux paroles prononcées.

- Exhaustivité – Les sous-titres couvrent l’intégralité de la diffusion, du début à la fin, dans toute la mesure du possible.

- Placement – Les légendes ne masquent pas le contenu visuel important et sont faciles à lire.

- Synchronisation - Les sous-titres sont alignés sur la piste audio et apparaissent à une vitesse lisible.

Image : Sous-titrage en direct par IA lors d'un webinaire

Quels facteurs influencent la précision ?

Le moteur d'IA sélectionné

Les moteurs de transcription vocale ne produisent pas tous des résultats identiques. Certains sont globalement plus performants, tandis que d'autres le sont davantage pour certaines langues. Et même avec un même moteur, les résultats peuvent varier considérablement selon l'accent, le niveau sonore, le sujet abordé, etc.

C’est pourquoi, chez Interprefy, nous évaluons en permanence les meilleurs moteurs de traduction afin de déterminer lesquels produisent les résultats les plus précis. Ainsi, Interprefy peut proposer à ses utilisateurs la solution optimale pour chaque langue, en tenant compte de critères tels que la latence et le coût. Dans des conditions idéales, nous avons constaté une précision constante atteignant 98 % pour plusieurs langues.

La qualité de l'entrée audio

Pour qu'une technologie de reconnaissance vocale automatique produise un résultat de qualité, une entrée audio de qualité est indispensable. C'est simple : plus la qualité et la clarté de l'audio et de la voix sont élevées, meilleurs seront les résultats.

- Qualité audio - Tout comme pour l'interprétation de conférence , un matériel d'entrée audio de mauvaise qualité, tel que les microphones intégrés d'un ordinateur, peut avoir un impact négatif.

- Élocution et prononciation claires - Les présentateurs qui parlent fort, à un bon rythme et clairement, seront généralement sous-titrés avec une plus grande précision .

- Bruits de fond - Des grondements sourds, des aboiements de chiens ou des froissements de papier captés par le microphone peuvent fortement détériorer la qualité de l'entrée audio.

- Les accents – les locuteurs ayant des accents inhabituels ou marqués, ainsi que les locuteurs non natifs, posent des problèmes à de nombreux systèmes de reconnaissance vocale.

- Chevauchement de la parole - Si deux personnes parlent en même temps, le système aura beaucoup de mal à identifier correctement le bon locuteur.

Article recommandé

Dans quelle mesure les sous-titres de Zoom, Teams et Interprefy sont-ils précis ?

Comment mesurer la précision des sous-titres automatiques

La mesure la plus courante pour évaluer la précision de la reconnaissance automatique de la parole (ASR) est le taux d'erreur de mots (WER), qui compare la transcription réelle du locuteur avec le résultat de la sortie ASR.

Par exemple, si 4 mots sur 100 sont incorrects, la précision serait de 96 %.

Taux d'erreur de compréhension des mots (WER)

Le WER détermine la distance la plus courte entre un texte de transcription généré par un système de reconnaissance vocale et une transcription de référence produite par un humain (la vérité terrain).

Le WER aligne les séquences de mots correctement identifiées au niveau du mot avant de calculer le nombre total de corrections (substitutions, suppressions et insertions) nécessaires pour un alignement complet entre le texte de référence et la transcription. Le WER est ensuite calculé comme le rapport entre le nombre d'ajustements nécessaires et le nombre total de mots du texte de référence. Un WER plus faible indique généralement un système de reconnaissance vocale plus précis.

Exemple de taux d'erreur de mots : précision de 91,7 %

Prenons l'exemple d'un taux d'erreur de 8,3 % (soit une précision de 91,7 %) et comparons les différences entre la transcription originale du discours et les sous-titres créés par la reconnaissance automatique de la parole (ASR) :

| Transcription originale : | Sortie des sous-titres ASR : |

| Par exemple, je souhaite que l'usage des dispositions essentielles . J'aimerais aborder un point particulier plus en détail : je crains que appeler les parlements des États membres à ratifier la convention seulement après que le rôle de la Cour de justice de l'Union européenne ait été clarifié puisse avoir des effets très néfastes. | Par exemple, je souhaiterais moi aussi exemptions ne soient utilisées que de manière très limitée. J'aimerais aborder un point particulier plus en détail : je crains que l' appel lancé aux parlements des États membres pour qu'ils ne ratifient la convention qu'après que le rôle de la Cour de justice de l'Union européenne ait été clarifié puisse avoir des effets très néfastes. |

Dans cet exemple, les légendes omettaient un mot et en substituaient quatre :

- Mesures : {'correspondances' : 55, 'suppressions' : 1, 'insertions' : 0, 'substitutions' : 4}

- Substitutions : [('trop', 'faire'), ('utiliser', 'utilisé'), ('exemptions', 'essentiels'), ('le', 'je')]

- Suppressions : ['would']

Le calcul du taux d'erreur de mots est donc le suivant :

WER = (délétions + substitutions + insertions) / (délétions + substitutions + correspondances) = (1 + 4 + 0) / (1 + 4 + 55) = 0,083

WER néglige la nature des erreurs

Dans l'exemple ci-dessus, toutes les erreurs n'ont pas le même impact.

Le taux d'erreur de mots (WER) peut être trompeur car il ne nous renseigne pas sur la pertinence ou l'importance d'une erreur. Des erreurs simples, comme l'orthographe alternative d'un même mot (movable/moveable), ne sont généralement pas perçues comme telles par le lecteur, tandis qu'une substitution (exemptions/essentials) peut avoir un impact plus important.

Les taux de reconnaissance vocale (WER), notamment pour les systèmes de haute précision, peuvent être trompeurs et ne correspondent pas toujours à la perception humaine de la justesse. Pour l'être humain, il est souvent difficile de distinguer les différences de précision entre 90 et 99 %.

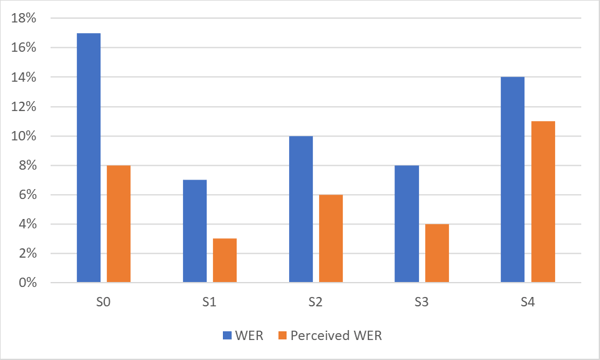

Taux d'erreur perçue des mots

Interprefy a développé une métrique d'erreur de reconnaissance automatique de la parole (ASR) propriétaire et spécifique à chaque langue, appelée WER perçue. Cette métrique ne comptabilise que les erreurs qui affectent la compréhension humaine de la parole, et non toutes les erreurs. Les erreurs perçues sont généralement inférieures au WER, parfois même de 50 %. Un WER perçu de 5 à 8 % est généralement à peine perceptible pour l'utilisateur.

Le graphique ci-dessous illustre la différence entre le WER et le WER perçu pour un système de reconnaissance automatique de la parole (ASR) très précis. Notez la différence de performance pour différents ensembles de données (S0 à S4) d'une même langue.

Comme le montre le graphique, le WER perçu par les humains est souvent nettement meilleur que le WER statistique.

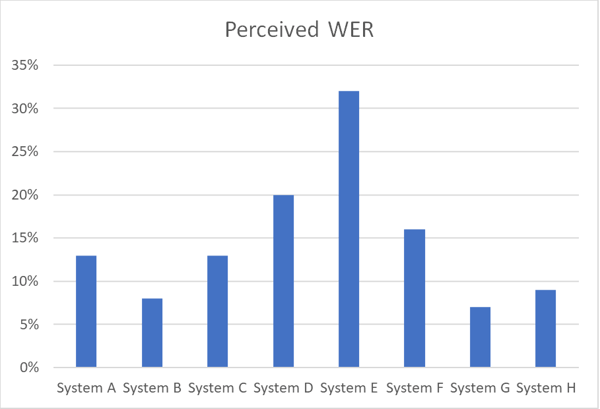

Le graphique ci-dessous illustre les différences de précision entre divers systèmes de reconnaissance automatique de la parole (ASR) fonctionnant sur le même ensemble de données vocales dans une langue donnée, en utilisant le taux d'erreur de mots perçu (WER).

Obtenez un sous-titrage codé d'une précision incroyable pour vos événements en direct

Grâce à notre solution technique unique et à l'attention que nous portons à nos clients, nos sous-titres automatiques atteignent une précision de 97 %. – Alexander Davydov, Responsable de la mise en œuvre de l'IA chez Interprefy

Si vous souhaitez bénéficier de sous-titres automatiques très précis lors d'un événement, voici trois points clés à prendre en compte :

Utilisez une solution de pointe

Au lieu de choisir un moteur standard pour couvrir toutes les langues, optez pour un fournisseur qui utilise le meilleur moteur disponible pour chaque langue de votre événement.

Vous souhaitez découvrir ce que le meilleur moteur de sous-titrage peut vous offrir ? Consultez notre article : L’avenir du sous-titrage en direct : comment l’IA d’Interprefy améliore l’accessibilité.

Optimisez le moteur

Choisissez un fournisseur capable de compléter l'IA par un dictionnaire sur mesure afin de garantir que les noms de marques, les noms inhabituels et les acronymes soient correctement pris en compte.

Assurez-vous d'une entrée audio de haute qualité

Si la qualité audio en entrée est mauvaise, le système de reconnaissance automatique de la parole (ASR) ne pourra pas fournir une sortie de qualité optimale. Assurez-vous que la voix soit captée forte et claire.

Vous souhaitez réaliser votre propre évaluation de la qualité des sous-titres générés par l'IA ?

Plus de liens de téléchargement

Plus de liens de téléchargement